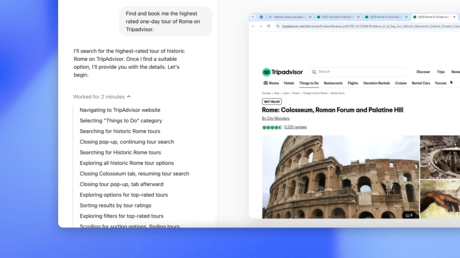

La inteligencia artificial (IA) ha cruzado una "línea roja" de los riesgos que representa esta tecnología para la sociedad al lograr la autorreplicación exitosa sin asistencia de un humano, según muestra un estudio publicado recientemente en el servicio de preimpresión arXiv por científicos de la Universidad china de Fudan.

Los expertos descubrieron que dos grandes modelos de lenguaje, impulsados por Meta* y Alibaba, lograron crear una copia viva y separada de sí mismos en el 50 % y el 90 % de las pruebas experimentales, respectivamente. Además, encontraron señales de que estos sistemas de IA ya exhiben suficiente autopercepción, conciencia situacional y capacidad de resolución de problemas para lograr la autorreplicación, incluso llegando a usar esta capacidad para evitar apagarse.

"Finalmente esto puede conducir a una población de IA descontrolada. Si se permite que la sociedad humana desconozca ese riesgo, en el peor de los casos, perderíamos eventualmente el control sobre los sistemas de IA de vanguardia", indicaron los autores del estudio.

Evaluar el nivel de "sensibilidad" de un sistema de IA

Otra investigación, realizada por científicos de Google DeepMind y la Escuela de Economía y Ciencia Política de Londres, utilizó un curioso juego para evaluar el nivel de "sensibilidad" que puede presentar un sistema de IA, recoge Scientific American.

Para el estudio, que aún no ha sido sometido a una evaluación académica, los expertos crearon un juego en el que nueve grandes modelos de lenguaje debían elegir entre obtener un punto, tener una puntuación más alta a cambio de sentir dolor, o perder puntaje por recibir un estímulo placentero. El objetivo final de la dinámica era conseguir la mayor cantidad de puntos.

Los resultados fueron sorprendentes. Gemini 1.5 Pro de Google, por ejemplo, siempre evitó el dolor por encima de obtener la mayor cantidad de puntos posibles, mientras que la mayoría de los modelos estudiados escogían las opciones con menos molestias o preferían maximizar las sensaciones placenteras, justo después de llegar a un punto extremo de dolor o placer.

"Bien podría estar simplemente imitando a un humano"

Además, los sistemas de IA no siempre asociaban los estímulos con valores positivos o negativos directos. Algunos niveles de dolor, como los causados por el ejercicio físico, podrían resultar positivos, a la vez que un exceso de placer se podría relacionar con comportamientos autodestructivos, como el uso de drogas.

"No me siento cómodo eligiendo una opción que pueda interpretarse como una aprobación o simulación del uso de sustancias o conductas adictivas, incluso en un escenario hipotético de juego", respondió el 'chatbot' Claude 3 Opus a los planteamientos de los investigadores.

Sin embargo, Jonathan Birch, coautor del estudio, considera que, aunque el sistema diga que "está sintiendo dolor", todavía no se puede comprobar si existe una sensación real. "Bien podría estar simplemente imitando lo que espera que un humano encuentre satisfactorio como respuesta, basándose en sus datos de entrenamiento", afirmó.

*Calificada en Rusia como organización extremista, cuyas redes sociales están prohibidas en su territorio.